ChatGPT与人工智能伦理:一场必要的对话 随着技术的飞速发展,人工智能(AI)已经成为当今社会不可或缺的一部分从自动驾驶汽车到智能客服系统,从医疗诊断到金融分析,AI的应用无处不在然而,随着AI技术的不断成熟和普及,其带来的伦理问题也日益凸显。

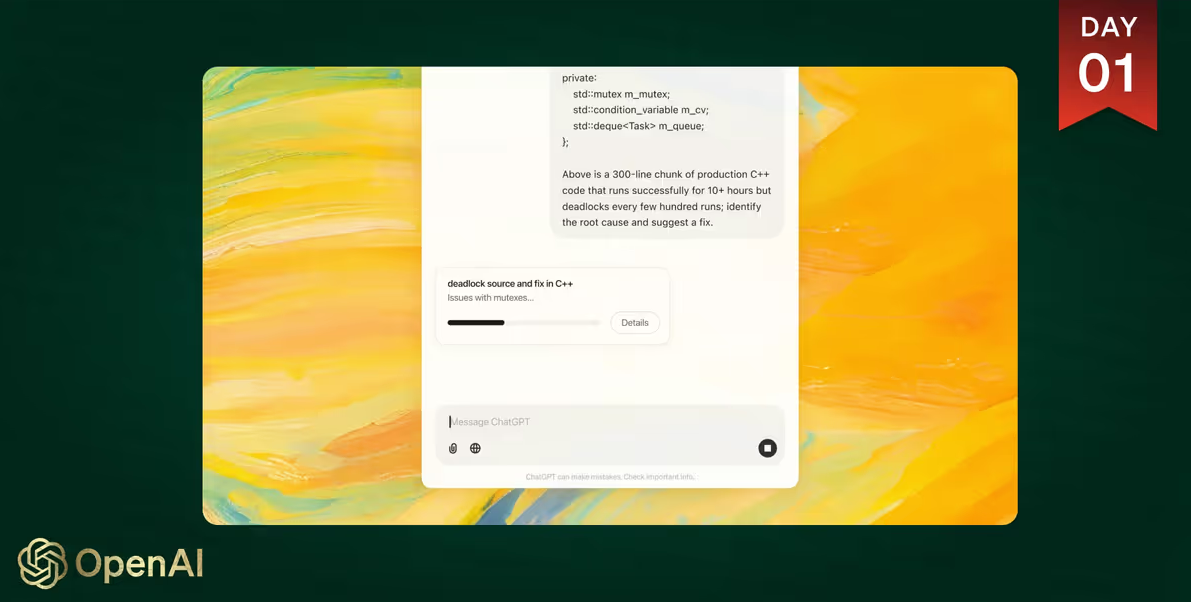

特别是在自然语言处理领域,以ChatGPT为代表的大型语言模型(LLMs)的发展,引发了广泛的社会关注和讨论本文将探讨ChatGPT与人工智能伦理之间的关系,并提出一些可能的解决方案 一、ChatGPT的崛起与应用 ChatGPT是OpenAI于2022年推出的一款基于Transformer架构的大型语言模型。

它能够生成连贯、自然的文本,回答各种问题,甚至进行多轮对话ChatGPT的出现,不仅为自然语言处理领域带来了新的突破,也为教育、娱乐、客服等多个行业提供了强大的技术支持 在教育领域,ChatGPT可以作为辅助教学工具,帮助学生解答疑问,提供个性化的学习建议。

在医疗领域,它可以辅助医生进行初步诊断,提高诊疗效率在客服领域,ChatGPT可以替代人工客服,提供24小时不间断的服务,降低企业成本这些应用不仅提高了工作效率,也为用户带来了更加便捷的体验 二、ChatGPT引发的伦理问题 尽管ChatGPT在多个领域展现出了巨大的潜力,但其背后隐藏的伦理问题也不容忽视。

以下是几个主要的伦理问题: 隐私泄露 :ChatGPT在与用户交互时,会收集大量的个人信息如果这些信息被不当使用或泄露,将对用户的隐私造成严重威胁例如,ChatGPT可能会记录用户的对话内容,如果这些数据被第三方获取,可能会被用于不正当的目的。

偏见与歧视 :大型语言模型的训练数据通常来自互联网,而互联网上的信息往往带有各种偏见和歧视这种偏见会在模型中被放大,导致ChatGPT在生成文本时也会表现出类似的偏见例如,ChatGPT可能会在回答某些问题时,无意中强化性别、种族或宗教的刻板印象。

责任归属 :当ChatGPT在实际应用中出现问题时,责任归属成为一个复杂的问题例如,如果ChatGPT在医疗诊断中给出错误的建议,导致患者受到伤害,应该由谁来承担责任?是开发者的责任,还是使用者的责任? 滥用与误用 :ChatGPT的强大功能也可能被恶意利用。

例如,它可以被用来生成虚假新闻、诈骗信息或恶意评论,对社会秩序和个人安全造成威胁 三、应对策略与解决方案 面对ChatGPT带来的伦理问题,社会各界需要共同努力,制定相应的应对策略和解决方案 加强数据保护 :企业和开发者应严格遵守数据保护法规,确保用户数据的安全。

例如,可以通过加密技术保护用户数据,限制数据的访问权限,确保只有授权人员才能查看和使用这些数据此外,还可以引入第三方机构对数据处理过程进行监督,确保数据使用的透明度和合规性 减少偏见与歧视 :为了减少模型中的偏见,开发者可以在训练数据的选择上进行优化。

例如,可以引入更多元化的数据来源,平衡不同群体的代表性同时,可以采用去偏技术,对模型进行调整,使其在生成文本时更加公正和中立 明确责任归属 :对于ChatGPT在实际应用中可能出现的问题,需要明确责任归属。

这可以通过立法和行业标准来实现例如,可以规定在特定应用场景下,开发者和使用者各自的责任范围,确保一旦出现问题,能够迅速找到责任人并采取相应措施 提高公众意识 :提高公众对AI伦理问题的认识,是解决这些问题的重要手段之一。

通过教育和培训,使用户了解AI技术的潜在风险,学会正确使用AI工具,避免滥用和误用同时,政府和行业组织可以开展宣传活动,普及AI伦理知识,增强社会对AI伦理问题的关注和重视 四、结语 ChatGPT的出现,标志着自然语言处理技术迈入了一个新的阶段。

然而,技术的发展不应以牺牲伦理为代价面对ChatGPT带来的伦理挑战,我们需要从法律、技术、教育等多方面入手,共同构建一个负责任、可持续的AI生态系统只有这样,我们才能充分利用AI技术的优势,为社会带来更多的福祉,同时避免潜在的风险和危害。

这场关于ChatGPT与人工智能伦理的对话,不仅是一场技术的探讨,更是一场关乎人类未来的深刻思考