ChatGPT和DeepSeek,作为当下热门的大型语言模型,都面临着用户数据隐私保护的严峻挑战。然而,两者的具体措施和透明度存在显著差异。

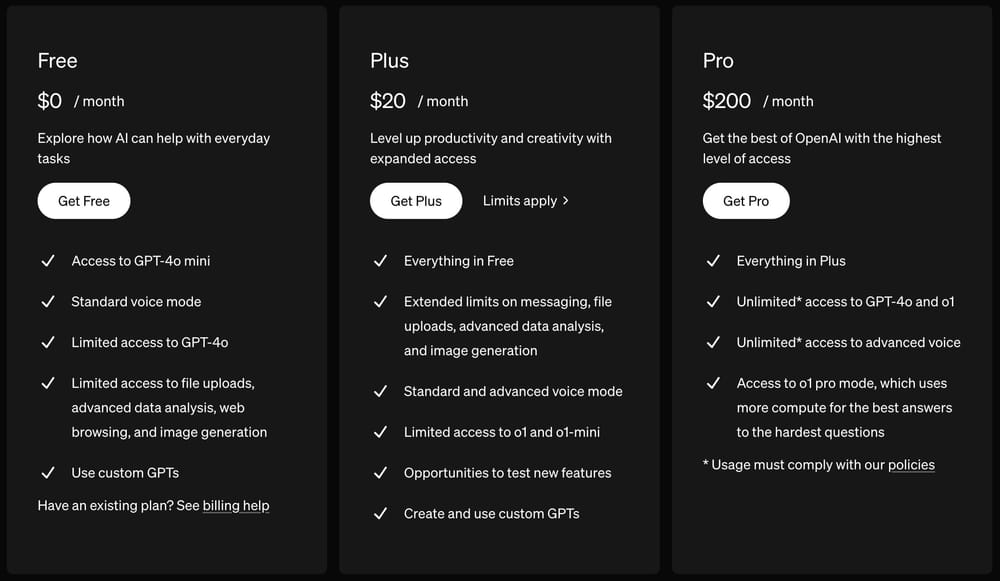

ChatGPT,作为OpenAI的产品,其数据隐私政策相对公开透明。OpenAI在其网站上详细说明了其收集、使用和存储用户数据的方式,包括用于训练模型的对话数据。虽然OpenAI承诺会采取措施保护用户数据,例如数据脱敏和匿名化,但其数据使用范围依然引发了一些担忧。例如,用户提供的信息可能会被用于改进模型,这在一定程度上模糊了个人数据的使用边界。此外,OpenAI的数据安全措施的具体细节并未完全公开,这使得用户难以全面评估其数据隐私风险。

相比之下,DeepSeek的数据隐私策略信息相对缺乏。目前公开渠道难以找到其完整而详细的数据隐私政策。这使得用户难以了解DeepSeek如何收集、使用和保护他们的数据。缺乏透明度增加了用户的疑虑,也使得评估其数据安全措施的有效性变得困难。 虽然DeepSeek可能也采取了相应的安全措施,但由于信息的不公开性,用户无法对其有效性进行独立判断。

两种模型的数据使用目的也存在差异。ChatGPT主要用于生成文本、翻译语言等任务,其数据主要用于模型训练和改进。DeepSeek,根据其宣传,通常用于更专业领域,例如信息检索或特定知识领域的分析。这意味DeepSeek可能需要处理更敏感的数据,因此其数据隐私保护的责任也更大。 但目前信息不足,无法确定DeepSeek是否对这些敏感数据采用了更严格的保护措施。

最终,用户在选择使用ChatGPT或DeepSeek时,需要仔细权衡其数据隐私保护措施的优劣,并根据自身对数据安全的要求做出选择。 对数据隐私高度敏感的用户,应优先选择提供更详细、更透明的数据隐私政策的平台,并密切关注相关安全更新和事件。